AI發展-麻省理工學院教授Max Tagmark 的新書Life 3.0:

Being Human in the Age of Artificial Intelligence 得到包括Elon Musk 等人的力荐,

書中暢想了一個人工智能驅動的未來,敦促我們盡快採取行動來決定未來,而不是等待未來。

內容目錄

技術史是人類不斷被取代的歷史

幾年前,Max Tegmark 站在南肯辛頓科學博物館門外哭了。

他剛剛參觀了一個展示人類知識增長的展覽,

觀看了從查爾斯巴貝奇差分機到阿波羅11號複製品的一系列展品。

讓他流淚的不是這些里程碑技術的外表奇觀,而是它們所展示的對真相的頓悟。

「我就像被磚塊擊中了一樣。」他回憶說,

「每當我們深入了解了自然中的某些東西,我們自己身心的某些方面就會變得過時、多餘。

一旦我們理解了肌肉如何工作,我們就會以機器的形式造出更好的肌肉;

也許當我們理解我們的大腦如何工作時,

我們也將造出更好的人造大腦,這樣我們自己的大腦也會變得完全過時。」

Tegmark 進一步問自己: 如果我們創造出了超越我們智慧的超級智能,人類將變成什麼樣呢?

這個問題曾在科幻作品中一再出現。

然而,隨著AI成為科學事實,這個問題具有了非同尋常的意義和緊迫性。

Tegmark認為,我們必須研究圍繞人工智能的社會問題,特別是出現所謂超級智能的可能性。

Tegmark 與他的朋友、Skype聯合創始人Jaan Tallinn,

利用來自科技億萬富豪 Elon Musk的資金設立了未來生命研究所,研究人類面臨的存在風險。

它位於馬薩諸塞州劍橋。 Tegmark本人是麻省理工學院的教授。

AI是什麼,不是什麼

Tegmark 開始撰寫他的新書,《生命3.0:生活在人工智能時代》。

要看清AI的前景,一個巨大的困難在於,AI的概念已迷失於種種神話和誤解。

Tegmark試圖解決這個問題,仔細地展開 AI 所涉及的與智慧,

記憶,學習,意識相關的想法,逐一解釋它們,讓這些概念不再神秘。

首先,我們最應該明確的是,AI不是什麼。

「我認為,好萊塢對我們的引導是錯誤的。」他說。

「這種對機器人的意識和邪惡的恐懼是杞人憂天。高級人工智能的真正可怕之處不是邪惡,而是無能。

如果你擁有超級智能的AI,那麼根據設定,它將非常好地實現它的目標;

但我們需要確保,這些目標與我們的目標一致。

我並不仇恨螞蟻,但如果你讓我負責在蟻巢上建設綠色能源水電站,這對螞蟻來說將是毀滅性的。

在面臨超級智能時,我們可不想讓自己處於這些螞蟻的位置。」

《Life 3.0》並不是一部關於超級AI碾壓人類的哀歌。實際上,它對超級智能的潛力是樂觀的。

不過,什麼是超級智能?甚至,什麼是智能? Tegmark把智能定義為「完成複雜目標的能力」。

因此,普通計算機已具有智能。但是,它們的智能仍很狹隘。

目前,計算機在某些領域處理信息時遠遠超出人類。

例如,世界上最好國際象棋手已無法戰勝現代計算機象棋程序。

但是,如果讓這個程序與兒童玩最簡單的井字棋遊戲,它就會無能為力。

人類,即使人類中的孩子,都在廣泛領域中擁有通用智力。而電腦的處理能力只限於規定的任務。

所以對普通計算機來說,它們只會達到我們通過編程所要求它們達到的那種聰明程度。

但是,隨著進入AI時代,計算機開始改變了。

在Google的AI子公司DeepMind等地方,電腦已可以通過自學習 ,進行反复嘗試和進步。

到目前為止,這類技術只在視頻遊戲和圍棋中得到體現,但將來可能會擴展到其他媒體。

如果它擴展得足夠遠,將對我們如何看待對自己、如何看待生活,以及其他根本問題產生深遠的影響。

生命的三個階段

Tegmark 研究這些問題的方式是,設想一個具有發展階段的生命歷程。

他把最原始的生命形式,如細菌,他稱之為Life 1.0。

這是一個最簡單的生命階段,生命只是在不停複製,而適應只有通過自然進化才有可能。

Life 2.0階段或所謂文化階段是人類所在的地方:

人類能夠學習,適應不斷變化的環境,並能有意地改變這些環境。

然而,我們還不能改變我們的身體自身,不能改變我們的生物遺傳。

Tegmark將這種對比比喻成軟件和硬件之間的對比。

我們已經能設計自己的文化軟件,能設計我們「走路,閱讀,寫作,計算,唱歌和說笑話」的能力;

但是我們的生物硬件,包括我們的大腦和身體的特徵,仍受到自然進化的限制。

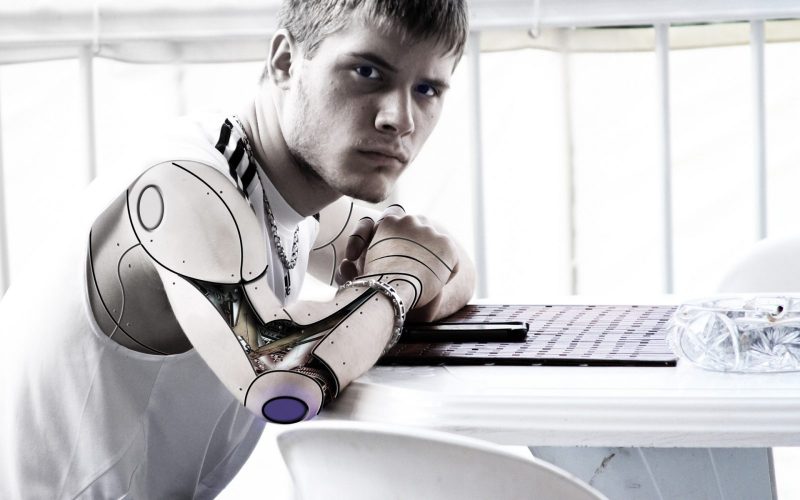

第三個階段,即Life 3.0階段,是高科技階段。

在這個階段,後期人類不僅可以重新設計自身的軟件,還可以重新設計自身的硬件。

Tegmark 寫道,這種形式的生命將是「自己命運的主人,最終完全擺脫自然進化的束縛」。

這種新的智能將是不朽的,並將在整個宇宙中擴散。這將是一種我們尚不知道的生命形式。

但是,這到底是生命嗎,還是別的什麼東西?作為一名物理學家,Tegmark 可不是關於生命的感傷主義者。

他是一名唯物主義者,將世界乃至宇宙視為由不同層次的粒子組成,具有不同層次的活動。

在他看來,普通人的生物性智能與自我維持的機器智能之間沒有任何有意義的、道德上的區別。

Tegmark描述了Life 3.0的無限可能性的未來。

在書中,有時他的寫作是夢幻般的;

有時他又會像理論家一樣,試圖構想我們大多數人難以想像、不樂意想像的東西。

簡單來說,我們正處於AI 的早期階段,面臨自駕車、智能家居控制單元等自動機器。

但是,如果趨勢持續快速發展,那麼,在30年,50年或200年後的某個時刻,

計算機將以達到人類的一樣的通用智能。一旦電腦達到這個階段,他們的改善將迅速加快,

因為它們將能夠用已有的處理能力來計劃如何提高自己的處理能力。

這就是 Bostrom 在他2014年的「 超級智能」一書中所闡述的觀點。

這種智能大規模擴張的結果,將是超級智能或所謂奇點的到來。

然而,超級智能的來臨並不是不可避免的。有很多人認為電腦永遠不能與人類智能相匹配,

有些人認為如果電腦朝這個方向發展,人類本身也會學會適應。

但是,Tegmark認為,我們迫切需要認真思考超級智能來臨的可能性。

「我們處於這樣的時代:真正戲劇性的大事可能在幾十年內發生。

對我來說,這是人類開始為此準備的最好時候,這樣才能讓超級智能成為一個好的力量。

設想一下,如果我們30年前就為氣候變化做好準備,那麼氣候的現狀會好得多。」

AI的發展比氣候變化問題更為迫切

像Bostrom一樣,Tegmark認為AI的發展比氣候變化問題更為迫切。

然而,如果我們正在創造一種我們不可能理解的智能,

我們所做的準備對未來的超級智能又能有多大的影響呢?

我們如何才能嘗試限制那種超出我們想像的智力?

Tegmark承認,這是一個沒有人可以回答的問題,但他認為還有許多任務值得我們優先考慮。

「在我們擔心超級智能的長期挑戰之前,我們需要解決一些非常短期的問題。

‘完美’並不是’好’的敵人,即使做不到完美,我們也能讓現實變好一點。

在任何情況下,我們都不希望飛機撞進高山或建築物。

當事故飛機飛行員Andreas Lubitz 感到抑鬱崩潰時,他告訴他的自動駕駛儀,

讓它下降100米,飛機的電腦系統居然執行了!然後就帶來了災難。

這說明,這個電腦對於人類的目標是完全無知的。

儘管我們現在已經擁有飛機安全駕駛技術,在這種技術下只要飛行員試圖撞擊什麼東西,

飛機就會進入安全模式,將著陸目標鎖定在最近的機場。

但這樣的技術在這起災難中完全無用。我們應該著手,讓機器能夠理解這種幼兒園級的基本道德規範。」

不過,在此之前,還有更緊迫的工作要做。

「我們如何才能將今天的容易出錯、可攻破的計算機轉變成我們可以真正信任的強大AI系統?

這是非常重要的。 我覺得我們作為一個社會對這個問題太輕率了。

世界各國政府應該將這個領域作為計算機科學研究的重要組成部分。」

他認為,通過放棄人工智能研究來防止超級智慧興起,這並不是一個可靠的方法。

「人類在2017年的生活的每一個方面都比石器時代更好,這都是因為技術。

技術正在發生,沒有人會停止技術發展。如果有人問你是不是反對AI,這就像詢問你,

是不是反對火這個東西,這很可笑。我們都喜歡火,它讓我們的家庭保持溫暖,但我們也都想防止火災。」

在這本書中,Tegmark認為,Google的Larry Page可能成為有史以來最有影響力的人物:

「我的猜測是,如果超級智能在我的有生之年就誕生併吞噬天地,

這一切將起源於Larry Page所做出的決策。」

Larry Page 像 Musk一樣,富有思想,真誠關心人類的未來困境。

但毫無疑問,他首先是一個商人,最關心的是利潤和打敗競爭對手。

而事實證明,目前關於AI的決策權力仍過多地掌握在科技億萬富豪,而這些人並不能代表人類的利益。

關於近期的AI政策,Tegmark的建議是:

「第一,資助關於AI安全的研究,第二,禁止致命性的智能自主性武器,

第三,擴大AI的社會服務,讓AI創造的財富能使每個人都得到好處。 」

如前所述,今天的行動將極大影響未來的AI道路。

但是,採取這三點計劃,似乎能讓未來變得不那麼讓人擔憂。

原文出處/36Kr